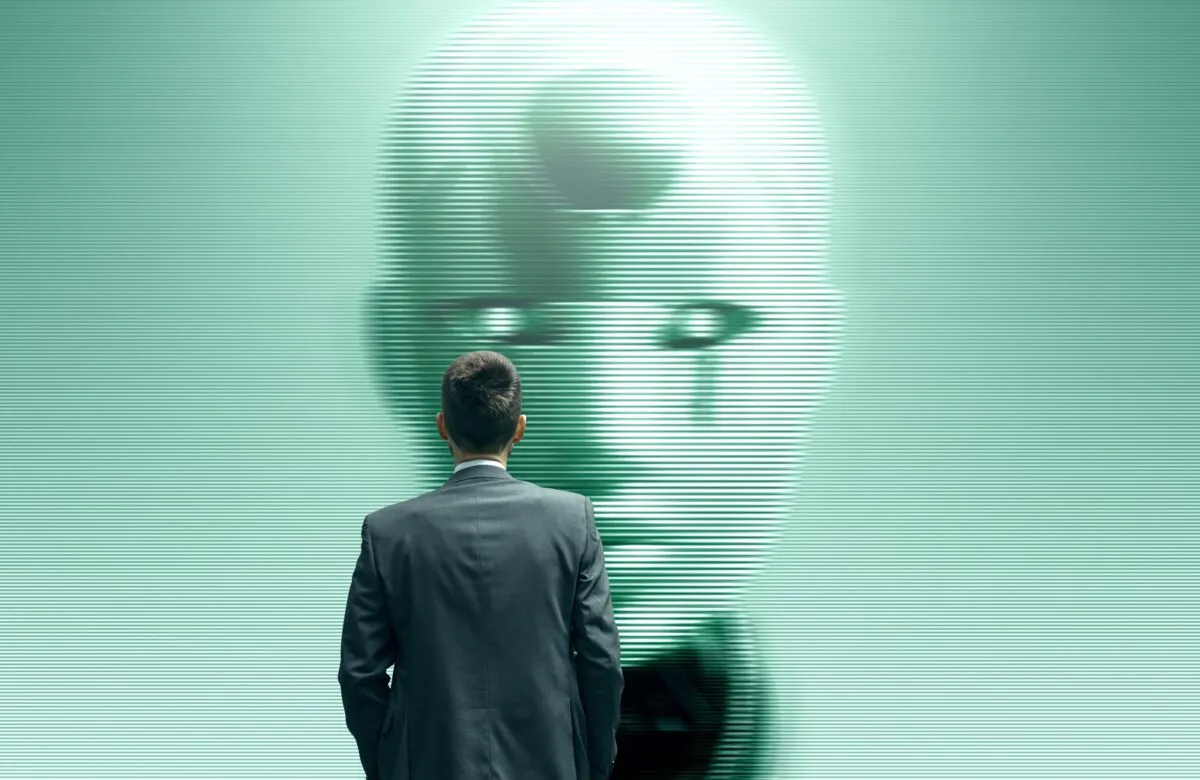

L’intelligence artificielle (IA) continue d’évoluer et de transformer les activités des entreprises, Toutefois, son adoption doit être responsable et digne de confiance. Encadrées par des réglementations telles que l’AI Act européen, des stratégies d’entreprise et des politiques éthiques, le déploiement de cette technologie doit s’effectuer de manière conforme.

Comment les organisations peuvent-elles garantir un déploiement éthique de l’IA ?

L’importance d’une IA éthique

Pourquoi l'éthique de l'IA est-elle nécessaire ?

Certains la considèrent comme un ensemble de directives souples plutôt qu'un cadre strict, tandis que d'autres l'assimilent à une simple conformité réglementaire. En réalité, l'éthique vise à assurer une meilleure utilisation de l'IA, plus responsable, en tenant compte de son impact sur la société et les individus. Les organisations doivent s'assurer que l'IA est alignée pour répondre à leur missions et leurs valeurs, tout en offrant un avantage tangible aux utilisateurs. Lorsque l’IA est perçue comme fiable, son adoption devient naturelle pour tous. Adopter largement une approche éthique pour l’IA peut paraître abstrait, voire irréaliste, mais la régulation peut accompagner ce changement. L’IA Act, par exemple, n’a pas pour vocation de réglementer l'IA dans son ensemble, mais plutôt d’évaluer et de réglementer chaque système d'IA, selon niveau de risque et son usage.

Ce cadre permet de classer les systèmes en quatre catégories :

• Risque inacceptable : interdiction des usages dangereux (ex : surveillance de masse, manipulation comportementale).

• Risque élevé : obligation de surveillance accrue (ex : IA dans la santé, la justice ou la finance).

• Risque limité : exigences de transparence pour informer les utilisateurs.

• Risque minimal : usage libre avec peu de contraintes.

Si cette classification définit des exigences minimales, de nombreuses organisations adoptent des normes plus strictes pour assurer un déploiement responsable.

Assurer l’équité de l’IA

L’équité est un aspect fondamental en matière d’éthique d’IA, qui ne se limite pas à la simple notion de justice. L'équité fait également référence à un principe beaucoup plus strict, visant à éviter toutes discrimination envers certaines catégories de population, basées sur des biais.

Ces biais peuvent provenir de plusieurs sources, telles que les règles intégrées dans le système et les données d'entrée exploitées, ou l’entraînement des modèles d'apprentissage automatique. Par exemple, il a déjà été démontré qu’un modèle destiné à la prévention des problèmes de santé, a été conçu pour prédire les coûts futurs des soins au lieu de l'évolution des maladies, défavorisant ainsi les patients ayant historiquement moins accès aux soins.

De même, nous savons désormais que certains modèles d’IA générative ont été entraînés à partir de sources telles que les forums en ligne ou les livres très anciens, car ceux-ci sont libres de droits.

Pour réduire ces biais, la mise en place d’une surveillance constante est essentielle. Celle-ci doit intégrer la mesure et l’analyse des biais, ainsi qu’un ajustement des données et modèles pour limiter les effets discriminatoires.

Grâce à une surveillance continue, les organisations seront en capacité de garantir que les systèmes d'IA sont conformes aux directives éthiques, ainsi qu'à d'autres principes tels que la confidentialité, la responsabilité, la transparence et la durabilité.

L'avenir de l'IA et de l'éthique

Certaines organisations craignent qu'une réglementation accrue ne freine l'innovation. Pourtant, nous pouvons déjà observer que les secteurs plus réglementés qui ont déployé une IA responsable, comme la finance, attirent davantage d'investissements et favorisent la confiance.

Avec l’adoption croissante de l'IA, les entreprises qui garantiront un déploiement responsable seront en mesure de faire évoluer leurs opérations basées sur l'IA beaucoup plus facilement et de favoriser l'engagement des utilisateurs finaux et des clients. En s'assurant que les systèmes répondent aux besoins des utilisateurs, les organisations peuvent accélérer l'adoption de l'IA sans risquer de subir des préjudices financiers ou de ternir leur réputation, et l'employer pour concrétiser leur mission d'entreprise tout en bénéficiant aux consommateurs, aux clients et aux citoyens.

L'émergence de l’IA autonome

L’autonomisation progressive de l’IA en entreprise pose de nouveaux défis. Toutefois, cela ne signifie pas nécessairement plus de réglementation, car la législation existante est suffisamment souple pour s'adapter à cette évolution. Ainsi, si l’AI Act ne mentionne pas spécifiquement l'IA agentique, elle fournit un cadre structuré pour réglementer toutes les applications de l'IA en fonction de leur niveau de risque potentiel.

Il est important que l'IA agentique soit déployée de façon transparente, et maîtrisée. Il est donc essentiel que les agents puissent évaluer les plans d’action des systèmes, n’aient accès qu’aux outils strictement nécessaires, et sachent reconnaître leurs limites – notamment pour faire appel à un humain en cas de demande hors périmètre, d’action critique ou d’usage d’outils sensibles. De plus, une vue d'ensemble de toutes les étapes automatisées effectuées par ces agents est essentielle pour l'interprétabilité, la transparence et la responsabilité.

Avec la généralisation de l’IA, les entreprises qui anticipent les enjeux éthiques et misent sur la transparence ne se contenteront pas de répondre aux exigences réglementaires – elles gagneront aussi un avantage concurrentiel en renforçant la confiance des utilisateurs et partenaires.

L'objectif final de l'IA doit être d'améliorer la prise de décision humaine, de générer des effets positifs sur la société et de faire en sorte que l'IA soit une force au service du bien.