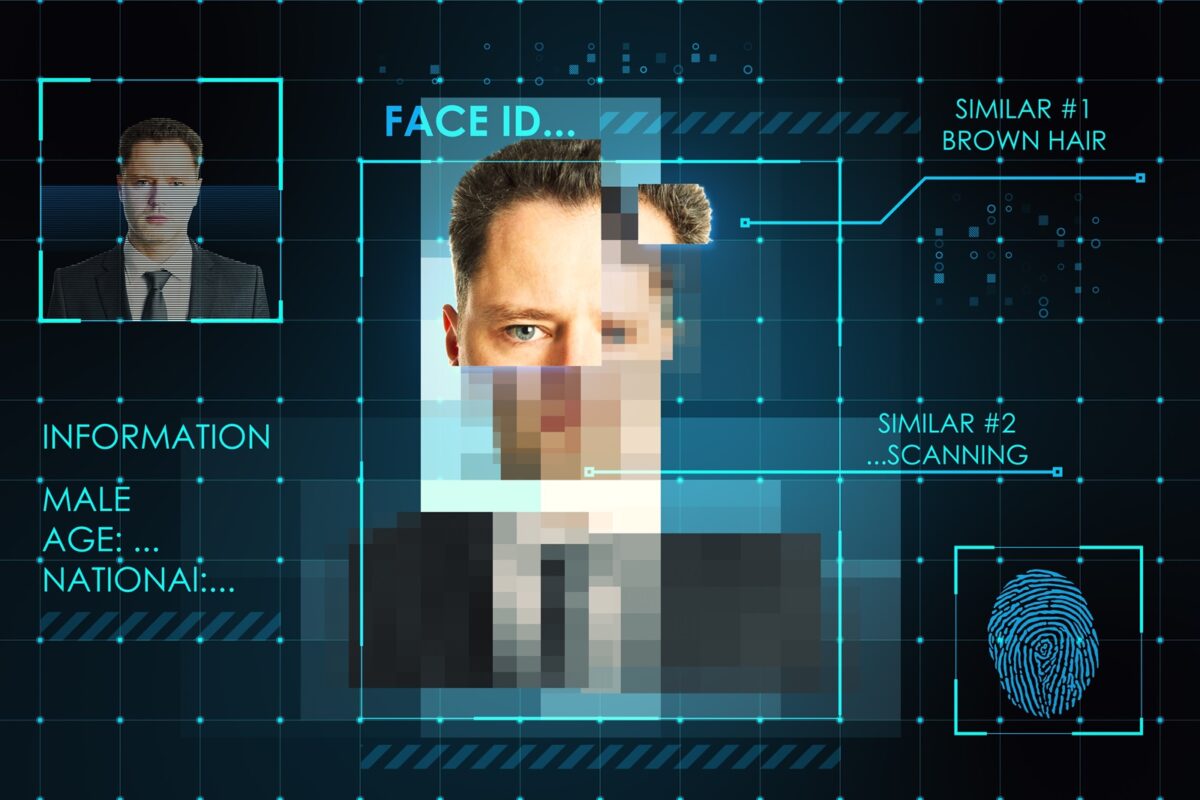

Je note depuis un certain temps l’utilisation croissante du terme « deepfake » dans l’actualité. Un deepfake désigne une vidéo numériquement trafiquée utilisée pour déformer, détourner les propos d’une personne, et falsifier son identité. Le plus récent exemple de deepfake a conduit au transfert réussi de 25 millions de dollars lors d’une vidéoconférence, attirant l’attention du grand public.

Deepfake : l’entreprise face à l’ingénierie sociale dopée à l’IA

Ce qui rend cette information particulièrement intéressante, c'est le détournement de fonds, rendu possible par la falsification d’un seul appel vidéo. Bien que la méthode de manipulation utilisée pour tromper la victime ne soit pas nouvelle, cet exemple de deepfake souligne à nouveau à quel point l'IA peut être sophistiquée lorsqu'elle est exploitée de manière créative.

Évolution des méthodes d'ingénierie sociale

Les attaquants adoptent les nouvelles technologies souvent plus rapidement que les défenseurs. L’un des exemple Classique bien connu date de l'ère des modems, où un malware pouvait composer des numéros payants, générant ainsi des factures exorbitantes. Plus récemment, des applications malveillantes sur des téléphones portables ont piraté des numéros payants , générant un profit rapide. C’est d’ailleurs une version moderne de l'ancienne tactique du "numéroteur de modem". Les cryptomineurs, exploitant la puissance de calcul des systèmes infectés, marquent la phase suivante de cette évolution.

Le facteur humain

L'utilisation de vieilles techniques d'ingénierie sociale persiste, avec des tactiques telles que la simulation de la voix d'un responsable d’entreprise en utilisant des clips audio en libre accès pour menacer les utilisateurs et les inciter à agir. Cependant, le fait de pouvoir truquer des enregistrements vidéo en direct pendant une vidéoconférence représente un nouveau palier effrayant de sophistication cybercriminelle, suscitant une peur légitime face à l'évolution technologique de l'intelligence artificielle. Cette situation souligne la facilité avec laquelle les individus peuvent être trompés ou contraints d'agir, permettant aux acteurs malveillants d'exploiter la situation à leur avantage de manière plus efficace grâce à la nouvelle technologie.

Sensibilisation du grand public

Malheureusement, le grand public ignore souvent la progression de ces techniques d'ingénierie sociale, sous-estimant leur vulnérabilité à de telles attaques. Les formations traditionnelles de sensibilisation à la sécurité sont remises en question, car les individus ne se considèrent pas comme des cibles potentielles. Pourtant, l'IA, opérant en continu avec un ciblage constant, accentue le facteur de risque humain.

Technologies pour contrer les playbooks

Bien que des technologies existent pour contrer les deepfakes, leur utilisation n'est pas généralisée. Il est crucial que les entreprises adaptent leurs processus de sécurité. Quelques recommandations inclueraient l'intégration de fonctions de confirmation de l'identité humaine lors des téléconférences, l'adoption du Zero Trust, et l'utilisation de technologies de tromperie pour détecter efficacement les anomalies.

L'exemple récent de transfert d'argent réussi grâce à un deepfake souligne l'importance pour les entreprises de vérifier le niveau de risque global dans leurs processus. La mise en place de processus administratifs solides pour atténuer les risques, non seulement dans la sécurité organisationnelle, mais également dans des opérations telles que l'authentification des paiements, renforcerait significativement leurs défenses contre d'éventuelles attaques. La technologie n'est pas une solution miracle, et l'adoption de procédures adaptées est essentielle pour prévenir d'importantes pertes financières, comme l'exige parfois une nouvelle procédure requérant la signature de deux personnes pour un transfert de fonds…cela afin d'éviter une perte de 25 millions de dollars par une entreprise.